Täuschende Gesichter: Kurzes Training verbessert die Erkennung von KI-generierten Gesichtern

Eine britische Studie zeigt, dass selbst Experten Schwierigkeiten haben, von künstlicher Intelligenz erstellte Gesichter zu identifizieren, aber ein nur fünfminütiges Training verbessert die Ergebnisse erheblich und eröffnet neue Strategien für die Bekämpfung von digitalem Betrug.

Bildgeneratoren, die auf künstlicher Intelligenz basieren, haben sich mit bemerkenswerter Geschwindigkeit weiterentwickelt. Innerhalb weniger Jahre sind sie in der Lage, menschliche Gesichter so detailreich und überzeugend zu erstellen, dass sie für viele Menschen sogar realistischer als echte Gesichter wirken. Dieser technologische Fortschritt stellt uns vor eine wachsende Herausforderung: Wie können wir ein authentisches Bild von einem durch Algorithmen erstellten Bild unterscheiden?

Eine neue Studie von Forschern aus Großbritannien liefert eine mögliche Antwort. Der Schlüssel liegt in der Kombination von außergewöhnlichen menschlichen Fähigkeiten mit kurzen, gezielten Schulungen. Den Ergebnissen zufolge könnte diese Strategie die Erkennung von KI-generierten Gesichtern erheblich verbessern – eine Fähigkeit, die in einer Welt voller digitaler Betrugsfälle und Falschinformationen immer wichtiger wird.

Supererkennende gegenüber typischen Menschen

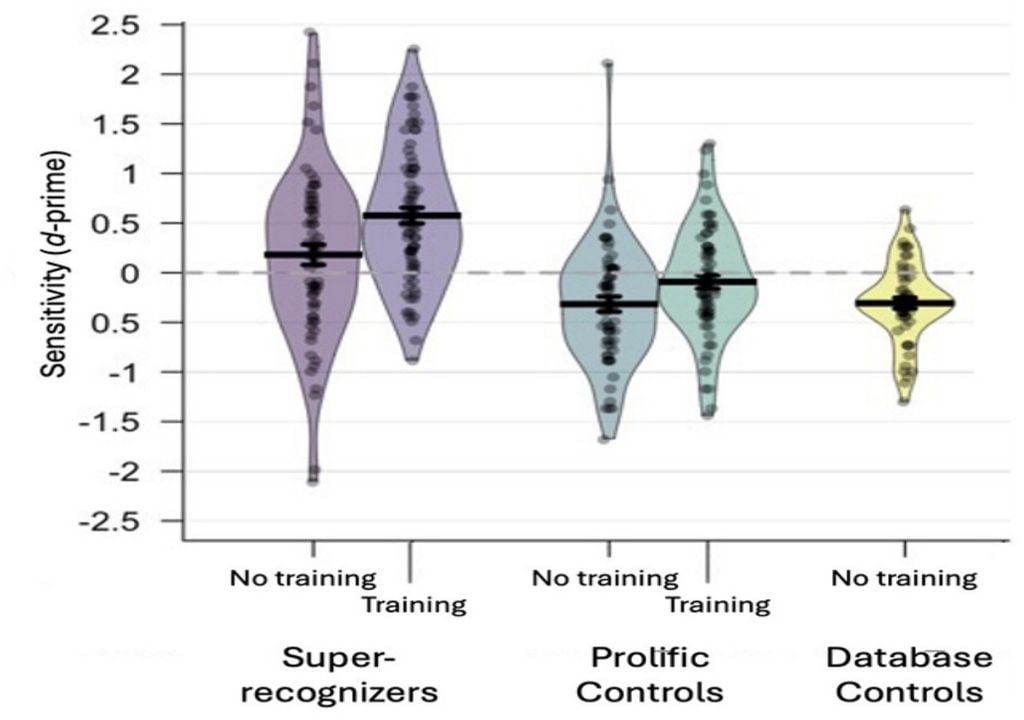

Die Studie untersuchte 664 Freiwillige, die in zwei Hauptgruppen unterteilt wurden. Eine Gruppe bestand aus sogenannten Super-Erkennern, also Personen, die in früheren Studien herausragende Fähigkeiten zur Identifizierung und zum Vergleich von Gesichtern gezeigt hatten. Die andere Gruppe bestand aus Teilnehmern mit typischen Gesichtserkennungsfähigkeiten.

Beide Gruppen wurden auf ihre Fähigkeit getestet, echte Bilder von KI-generierten Gesichtern zu unterscheiden. Erste Ergebnisse zeigten, dass die Super-Erkenner zwar überdurchschnittlich gut abschnitten, aber selbst sie große Schwierigkeiten hatten, gefälschte Bilder zu erkennen.

„Das Problem ist, dass KI-generierte Bilder immer einfacher zu produzieren und immer schwieriger zu identifizieren sind“, erklärte Eilidh Noyes, Psychologieforscherin an der Universität Leeds und eine der Autorinnen der Studie. „Das macht sie potenziell aus Sicherheitsperspektive gefährlich.“

Zwei Aufgaben, dieselbe Herausforderung

Die Studie umfasste zwei Arten von Aufgaben. Bei der ersten sahen die Teilnehmer ein einzelnes Gesichtsbild und mussten entscheiden, ob es echt oder KI-generiert war. Bei der zweiten wurden ihnen zwei Bilder gezeigt – eines echt und eines künstlich – und sie wurden gebeten, das gefälschte Bild zu identifizieren. Für jedes Experiment wurde eine andere Gruppe von Freiwilligen verwendet.

Unter denjenigen, die keine vorherige Schulung erhalten hatten, identifizierten Super-Erkenner die KI-generierten Gesichter in 41 Prozent der Fälle korrekt. Teilnehmer mit typischen Erkennungsfähigkeiten erreichten nur eine Genauigkeit von 31 Prozent. Da die Hälfte der Bilder gefälscht war, lagen diese Prozentsätze nahe am Zufall, was bestätigt, wie überzeugend ein künstliches Gesicht sein kann.

Die Wirkung von fünf Minuten Training

Der auffälligste Unterschied zeigte sich, als eine kurze Vorabschulung eingeführt wurde. In diesem Fall erhielten die Teilnehmer eine fünfminütige Schulung, die sich auf das Erkennen charakteristischer Merkmale von KI-generierten Bildern konzentrierte.

Zu den gelehrten Hinweisen gehörten subtile Details wie fehlende Zähne, Unregelmäßigkeiten in der Hautstruktur oder seltsame Unschärfen an den Rändern der Haare und des Gesichts. Nach dieser Vorbereitung änderten sich die Ergebnisse erheblich.

Teilnehmer mit typischen Fähigkeiten erreichten eine Genauigkeit von 51 Prozent, was in etwa dem Zufallsniveau entspricht. Super-Erkenner steigerten ihre Effektivität jedoch auf 64 Prozent, was weit über dem Zufallsniveau liegt.

„Unsere Studie zeigt, dass die Kombination von Super-Erkennern mit Training ein nützliches Instrument zur Erkennung von KI-generierten Gesichtern sein kann“, sagte Noyes.

Ein Problem mit Auswirkungen auf die reale Welt

Die Technologie hinter diesen Bildern basiert auf generativen gegnerischen Netzwerken (GANs), Systemen, in denen zwei Algorithmen miteinander konkurrieren: Der eine erstellt Bilder, der andere bewertet, wie realistisch diese im Vergleich zu echten menschlichen Gesichtern sind. Dieser ständige Feedback-Prozess ermöglicht immer überzeugendere Ergebnisse.

„Unser Trainingsverfahren ist kurz und einfach anzuwenden“, sagte Katie Gray, Forscherin an der Universität Reading. „Die Ergebnisse deuten darauf hin, dass es in Kombination mit den natürlichen Fähigkeiten von Supererkennern dazu beitragen könnte, reale Probleme wie die Online-Identitätsprüfung zu lösen.“

In einer digitalen Umgebung, in der das Erscheinungsbild keine Garantie mehr für Authentizität ist, bietet diese Art der Forschung sowohl eine Warnung als auch eine mögliche Verteidigungslinie.

Quellenhinweis:

Katie L. H. Gray, Josh P. Davis, Carl Bunce, Eilidh Noyes, Kay L. Ritchie; Training human super-recognizers’ detection and discrimination of AI-generated faces. R Soc Open Sci. 1 November 2025; 12 (11): 250921. https://doi.org/10.1098/rsos.250921